Por unas fotos

Dos rostros, una polémica: ¿es el algoritmo de Twitter racista?

La red social ha sido criticada por su sistema de recorte fotográfico, que en ocasiones antepone los rostros blancos a los negros. La propia compañía ha admitido el fallo, y ya está trabajando para hacer de su interfaz un lugar más igualitario. Hablamos con expertos para comprender lo ocurrido.

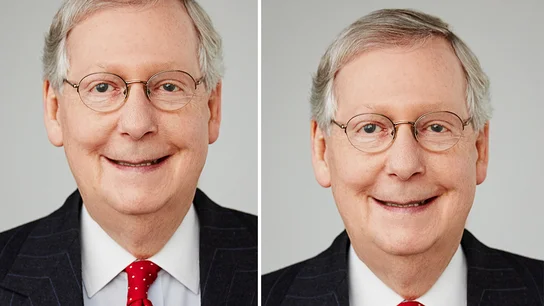

El pasado 20 de septiembre un usuario de Twitter, especializado en criptografía, decidió hacer un experimento —en principio, poco novedoso—: subir dos fotografías a una publicación. Sin embargo, no eran imágenes normales, estaban muy alargadas y contaban con un amplio espacio en blanco entre ellas. En el retrato inferior aparecía el expresidente de los Estados Unidos, Barack Obama y, en el superior, el político Mitch McConell, senador del Partido Republicano en el estado de Kentucky.

El problema no estaba en las imágenes en sí, sino en la decisión que tenía que tomar el algoritmo de Twitter a la hora de hacer su recorte (es decir, en elegir la imagen que se previsualiza en el tuit). Y ahí está la polémica: en el recorte de ambas fotos solo se previsualiza un rostro. El de McConell. Un rostro blanco. Y, según han podido apreciar los expertos, no es casual.

Este hecho ha provocado un creciente debate en las redes sociales. Multitud de usuarios han intentado hacer su aporte y han lanzado diferentes tipos de fotografías: contrastadas, sin contrastar, con personas blancas, negras... Todo para intentar hallar la respuesta a la siguiente pregunta: ¿Es el algoritmo de Twitter racista?

“Existe una teoría que dice que el algoritmo de Twitter ha sido malentrenado”, cuenta a laSexta.com Lluis Anaya, director de Innovación y Datos del Centro de Comunicaciones y Tecnologías de Cataluña (CTTI). Para lanzar un algoritmo, los desarrolladores deben pasar tres fases: entrenamiento, validación y producción.

En la primera, la compañía inyecta fotos y le dice al algoritmo que aprenda a buscar el mejor encuadre. Es ahí donde aparecen las suspicacias que apuntan a la red social: “Aquí se dice que Twitter ha entrenado a su algoritmo con fotos de hombres blancos. Es decir, que ha habido un sesgo”, espeta Anaya. Una suposición que rechaza el experto en Inteligencia Artificial: “Yo creo que no. Twitter no ha referenciado el blanco frente al negro, lo que ha hecho es entrenar al algoritmo para elegir el mejor encuadre”.

El director del CTTI cree que, efectivamente, hay un fallo en el sistema que decide el recorte de las fotos. Pero ese error no está en el entrenamiento del algoritmo: “Twitter no ha preferido al hombre blanco frente al hombre negro. Lo que ha hecho es establecer un algoritmo masivo para resolver esta pregunta: ¿Cuando me suben una foto, y esta puede ser de cualquier cosa, cuál es el mejor algoritmo que selecciona al sujeto?”, explica.

Por el contrario, según Anaya la clave podría estar en la segunda fase de desarrollo del algoritmo. Es decir, en la validación: “Cuando tú entrenas un algoritmo de Inteligencia Artificial, después hay que ver si acierta o no acierta”, indica. Aquí es donde el experto considera que ha fallado Twitter, en la aprobación de un modelo que, sin saberlo, contenía un error importante de identificación de contrastes: “Lo que ocurre es que validar absolutamente todos los casos por encuadre es muy complicado”.

Por otra parte, Marcelino Madrigal, bloguero informático que se dedica a denunciar los abusos que se cometen en Internet, lo tiene claro: “Un algoritmo no puede decirse que sea racista”. El experto cita un estudio llevado a cabo por la Universidad Carnegie Mellon (Pensilvania). En él se utilizan 92 imágenes de personas blancas y negras en Twitter “con la misma resolución y nivel de brillos” y, en este caso, la red social eligió más rostros negros (52) que blancos (40).

“No puede decirse que un algoritmo sea racista”

Madrigal explica que la selección de imágenes depende del contraste: “Si Obama hubiera estado vestido de blanco él hubiera sido elegido”, asegura, y le resta importancia al asunto señalando que muchos usuarios han realizado la prueba comparando animales e incluso tortillas. “¿Ahí también tiene Twitter un componente racista?”, bromea el experto.

Twitter admite el error: “Es 100% culpa nuestra”

LaSexta.com se ha puesto en contacto con Twitter para saber más sobre el funcionamiento de este algoritmo. La compañía reconoce el fallo, pero asegura que, hasta hace muy poco, no era consciente de ello: “Nuestro equipo hizo pruebas de sesgo antes de lanzar el modelo y no encontró evidencia de sesgo racial o de género en nuestras pruebas”, señala por correo Elena Bule, directora de Comunicación de Twitter España.

No obstante, este pequeño experimento ha servido para romper algunos de los esquemas de la red social: “A partir de estos ejemplos queda claro que tenemos más análisis por hacer. Continuaremos compartiendo lo que aprendemos, las acciones que tomamos y abriremos nuestro análisis para que otros puedan revisar y replicar”, concluye la entidad.

"Es maravilloso que haya pruebas abiertas y rigurosas sobre esto, y estoy ansioso de aprender de ello"

En esta línea, son varios los directivos de Twitter que han salido a responder ante la polémica. Como era de esperar, a través de unos tuits: “Es 100% culpa nuestra. Nadie debería decir lo contrario. Ahora el siguiente paso es arreglarlo”, escribe Dantley Davis, director de diseño de la compañía.

“Hicimos un análisis de nuestro modelo cuando lo enviamos, pero necesita una mejora continua. Es maravilloso que haya pruebas abiertas y rigurosas sobre esto, y estoy ansioso de aprender de ello”, concluye Parag Agrawal, director de Tecnología.

Inteligencia Artificial y ética, dos conceptos difíciles de aunar

Lluis Anaya explica el complejo funcionamiento de los algoritmos: “Son como cajas negras. A veces aprenden y toman decisiones que los humanos no sabemos explicar”. Esta conclusión hace que corregir los fallos originados en la Inteligencia Artificial a veces sea mucho más complicado de lo que parece: “No es corregir una línea de código”, asegura el experto.

Por eso, el reconocimiento facial entre personas blancas y negras se vuelve también un reto: “Hay estudios que muestran que esto es más difícil, porque hay menos contraste: por ejemplo, las cejas de una persona negra, para el algoritmo, se confunden con la tez”, explica Anaya, que resume: “Twitter ahora tiene que ajustarlo para que no sea así”.

“Los algoritmos son como cajas negras. A veces aprenden y toman decisiones que los humanos no sabemos explicar”

El cómo se ha diseñado el algoritmo también tiene mucho que decir, especialmente por el objetivo con el que se hace: ser lo más eficiente posible, al menor coste y tiempo. “Twitter tiene como premisa que las imágenes se suban rápidamente a su red social. Y este es un proceso lento y caro”, afirma Marcelino Madrigal.

Para Madrigal, la clave está en dejar de concebir a los algoritmos como termómetros de popularidad: “Si el modelo de Twitter funcionara por relevancia, lo normal es que la imagen de Obama fuera la elegida”, apunta. No obstante, el estudio que se hace para dictaminar qué se recorta es muy diferente a lo que se podría pensar: “Funciona con redes neuronales. Y la relevancia se calcula en función de parámetros como el contraste de la imagen”. Es decir, como cuenta la propia compañía, lo que prima es identificar los objetos más interesantes.

Aun así, según los expertos, el complicado manejo de la tecnología no implica que se deba obviar el resultado de los recortes: “En el algoritmo de Twitter hay una pieza que no está bien. Para eso está la inteligencia mixta, para que el equipo humano pueda solventar estos errores. Pero todo esto avanzará, seguro, ahora no estamos más que en el primer estadio”, concluye Anaya.