EN UN 88%

Una herramienta reduce el sesgo de los análisis de muestras cancerosas realizados con IA

Un equipo de Harvard ha analizado los cuatro modelos más populares de análisis patológico con inteligencia artificial para diagnosticar el cáncer y ha detectado sesgos ligados al género, la raza y la edad. Para corregirlos, ha desarrollado FAIR-Path, una herramienta que reduce estos fallos en un 88%.

Publicidad

El uso de la inteligencia artificial para analizar muestras patológicas ha supuesto un gran avance para el diagnóstico del cáncer en los últimos tiempos. Ahora, un grupo de investigadores ha descubierto sesgos que pueden disminuir la eficacia de estos modelos y ha desarrollado una herramienta para superarlos.

El estudio, dirigido por investigadores médicos de la Universidad de Harvard, en Estados Unidos, y publicado en la revista Cell Reports Medicine, revela que los modelos de IA para el diagnóstico del cáncer pueden inferir información demográfica de las diapositivas de patología, lo que genera sesgos que reducen la precisión en la evaluación del tumor.

Al analizar los cuatro modelos más populares de análisis patológico con IA diseñados para diagnosticar el cáncer, los investigadores encontraron un rendimiento desigual en la detección y diferenciación de cánceres en función del género, la raza y la edad.

Alimentaron los cuatro modelos de IA con un gran repositorio de diapositivas de muestras patológicas de 20 tipos de cáncer y comprobaron que todos ellos daban diagnósticos menos precisos para algunos grupos poblacionales.

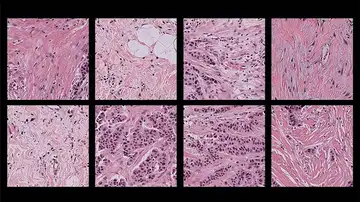

"Para un patólogo humano, observar una muestra de tejido rosado salpicada de células moradas es como calificar un examen sin nombre: la diapositiva revela información esencial sobre la enfermedad sin proporcionar otros detalles sobre el paciente. Nos sorprendió que la IA sí lograra hacerlo", explica uno de los autores, Kun-Hsing Yu, investigador en informática biomédica y patología en Harvard y en el Hospital Brigham and Women's de Boston.

Los investigadores "alimentaron" los cuatro modelos de IA con un gran repositorio de diapositivas de muestras patológicas de 20 tipos de cáncer y comprobaron que todos ellos daban diagnósticos menos precisos para algunos grupos poblacionales.

Por ejemplo, los modelos presentaban dificultades para diferenciar los subtipos de cáncer de pulmón en pacientes hombres afroamericanos; los subtipos de tumor de mama en pacientes más jóvenes; o, directamente, mostraban deficiencias al detectar cáncer de mama, riñón, tiroides y estómago en determinados grupos.

Patrones poblacionales sesgados

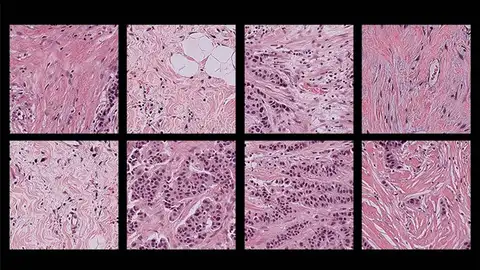

En general, los científicos detectaron deficiencias en un 29% de las tareas de diagnóstico realizadas por los modelos patológicos basados en IA, lo que, según Yu, se debe a que logran extraer información demográfica de las diapositivas y se apoyan en patrones poblacionales sesgados para realizar el diagnóstico.

Los investigadores atribuyen los sesgos a diferentes motivos. Por un lado, los modelos de aprendizaje automático se entrenan con tamaños de muestra desiguales (por poblaciones), lo que dificulta un diagnóstico preciso para grupos poco representados.

Al comprobar que los modelos también fallaban con tamaños de muestra comparables, los autores hicieron un análisis más profundo que reveló que los errores se debían a diferencias en la incidencia del cáncer.

Es decir, algunos tumores son más comunes en determinados grupos poblacionales, por lo que los modelos mejoran en esos casos, pero tienen más dificultades con aquellos en los que esos tipos de cáncer son menos habituales.

Los modelos de IA también detectan diferencias moleculares en muestras de distintos grupos demográficos, de modo que pueden identificar mutaciones en los genes que provocan el cáncer y utilizarlas como indicador del tipo de tumor. Esto los hace menos eficaces para diagnosticar en poblaciones donde esas mutaciones son menos frecuentes.

"Descubrimos que, debido a su gran potencia, la IA puede diferenciar muchas señales biológicas sutiles que no pueden detectarse mediante el análisis humano", afirma Yu en un comunicado de la Universidad de Harvard.

Aprendizaje automático contrastivo

Para solventar estas deficiencias, los investigadores han desarrollado FAIR-Path, una herramienta basada en aprendizaje automático contrastivo, que consiste en añadir un elemento al entrenamiento de la IA para enseñar al modelo a enfatizar las diferencias entre categorías esenciales (los tipos de cáncer en este caso) y restar importancia a las diferencias entre categorías menos cruciales (grupos poblacionales).

Las deficiencias diagnósticas se redujeron en torno al 88% con la aplicación de FAIR-Path.

"El hallazgo es alentador", añade Yu, "porque sugiere que el sesgo puede reducirse incluso sin entrenar los modelos con datos completamente justos y representativos".

El investigador y su equipo colaboran con instituciones de todo el mundo para investigar el alcance del sesgo en la IA patológica en lugares con diferentes características demográficas y prácticas clínicas y patológicas.

También exploran formas de ampliar FAIR-Path a entornos con tamaños de muestra limitados. "El objetivo es crear modelos de IA para el análisis patológico más justos e imparciales que puedan mejorar la atención oncológica", concluye.

Publicidad