TIEMBLA, SIRI

Un juego de niños: engañar a los asistentes de voz es tan fácil como poner voz infantil

En general, la voz no es una llave fiable para custodiar la entrada al territorio digital de nuestras vidas. Se ha demostrado lo fácil que puede resultar engañar un sistema de reconocimiento de voz, ya sea suplantando a su legítimo dueño o empleando técnicas sofisticadas como órdenes camufladas en ultrasonidos.

Publicidad

Aunque todavía son la 'rara avis' en España, dispositivos inteligentes como Amazon Echo o Google Home se están colando cada vez en más hogares al otro lado del charco. Según un estudio reciente de Juniper Research, estos aparatos cumplirán las órdenes de los moradores de un 55% de los hogares estadounidenses en menos de cinco años: pondrán la música que elijan cuando ellos digan, apagarán y encenderán la tele o las luces cuando toque y despertarán a sus dueños con suavidad y entonando el parte meteorológico del día.

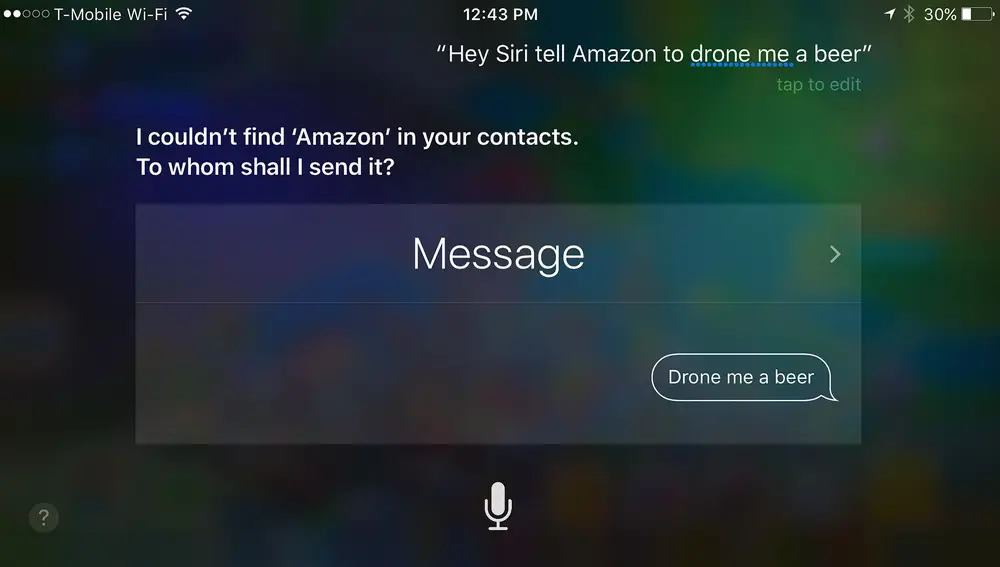

Algunas de estas tareas ya las desempeñan, también en nuestro país, mayordomos virtuales como Siri (de Apple), Google Assistant o Cortana (de Microsoft). Y todos ellos se basan en los mismo: nuestra voz, que se está convirtiendo en una puerta de entrada a internet y todos los servicios que eso conlleva, desde pedir una pizza o comprar entradas para el cine hasta revisar los movimientos de tu cuenta bancaria u ordenar una transferencia.

Y ahí está el mayor de sus peligros, porque la voz, como mecanismo de identificación biométrica, ofrece (incluso) menos garantías que la huella dactilar o el reconocimiento facial. Los sistemas que averiguan quién está hablando son propensos al fallo por diversas razones, como ya se ha demostrado varias veces. La última: un grupo de investigadores de la Universidad de Finlandia Oriental ha demostrado que engañar a esta tecnología es tan sencillo como impostar una aguda voz de niño.

En concreto, los académicos han averiguado que la tasa de error de los sistemas ASV (por las siglas en inglés de 'Automatic Speaker Verification', en español 'reconocimiento automático del hablante') se multiplica por once para los varones y por seis para las mujeres cuando tratan de sonar más jóvenes de lo que son. Por otra parte, la cantidad de veces que el 'software' se equivoca, ya sea confundiendo al locutor por otra persona o reconociendo a dos distintas como la misma, se multiplica por siete cuando un hombre trata de fingir más edad y por cinco cuando lo hace una mujer.

“La tarea del reconocimiento de voz es factible cuando los hablantes cooperan o desean ser reconocidos”, afirman los autores del trabajo. “Pero se vuelve notablemente difícil en situaciones en las que el hablante trata deliberadamente de camuflar su voz para enmascarar su identidad”.

Esto significa que es posible engañar a los sistemas de reconocimiento de voz hablando a una frecuencia más alta de lo habitual, es decir, poniendo voz aguda como la de un niño. Y no es la única forma. Un estudio previo de los mismos investigadores demostró que los sistemas ASV tienen problemas para distinguir la voz de las personas (en su caso, varios famosos de Finlandia) de la de un imitador profesional que intenta replicarlas.

En general, la voz no es una llave fiable para custodiar la entrada al dominio digital de una persona, tanto por razones biológicas (cambia con la edad, se ve alterado cuando estamos enfermos…) como por razones técnicas, sobre todo si se intentan usar 'voiceprints' (en castellano, algo así como huellas de voz). Porque supuestamente hay más de un centenar de marcadores únicos en cada timbre humano, basados en la configuración de la boca y la garganta del hablante, pero lo cierto es que parecen no haberse sabido usar de forma segura.

Hace unos meses, un periodista de la cadena pública británica BBC y su hermano gemelo lograron engañar sin esfuerzo al mecanismo antifraude del banco HSBC. “Lo verdaderamente alarmante es que el banco me permitió siete intentos erróneos de imitar la voz de mi hermano antes de que lo lograra en el octavo”, relataba preocupado el suplantador, que no sólo había podido consultar los movimientos del reportero, sino que incluso tuvo acceso a realizar transferencias.

En otros casos ni siquiera es necesario que un humano se haga pasar por quien no es. Recientemente, otro grupo de investigadores ha demostrado que Siri y los demás asistentes virtuales (o al menos los que ellos han probado) responden diligentemente a órdenes que no sólo no proceden de un humano, sino que ni siquiera son perceptibles para nuestro oído.

Así, comandos de voz enviados mediante ultrasonidos a los mayordomos de Apple, Google, Samsung, Huawei, Microsoft y Amazon pusieron en marcha las acciones deseadas sin que las personas pudieran darse cuenta de qué estaba sucediendo. Y eso no sólo hubiera permitido al atacante reproducir una canción concreta en el Spotify de su víctima, o gastarle una broma pidiendo una docena de hamburguesas, sino que hubiera hecho posible visitar un enlace y descargar ‘malware’ o activar la cámara y el micrófono para espiar cada uno de sus movimientos, entre otras muchas jugarretas.

A medida que el uso de la voz como llave de la faceta digital de nuestras vidas se vaya extendiendo, no sólo los ataques serán más y más frecuentes, sino también la cantidad de cosas que estos mayordomos podrán hacer por nosotros (como entrar en nuestra cuenta del banco) y de las que, por lo tanto, los que logren suplantarnos se podrán aprovechar.

Publicidad